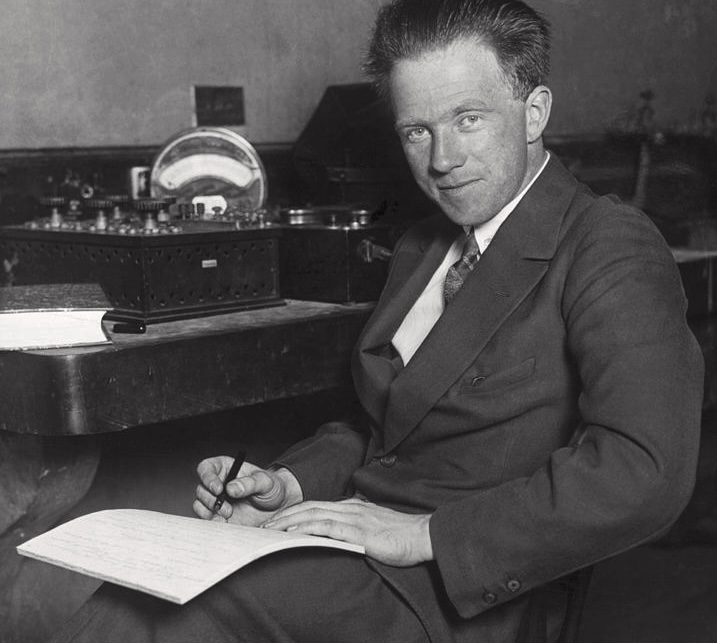

Heisenberg tra Fisica e Filosofia

Leggendo tra le righe: onde e particelle […] nella ricerca dell’armonia della vita, non dobbiamo dimenticarci che nel dramma dell’esistenza siamo insieme attori e spettatori….

Leggendo tra le righe: onde e particelle […] nella ricerca dell’armonia della vita, non dobbiamo dimenticarci che nel dramma dell’esistenza siamo insieme attori e spettatori….

Mileva Maric è stata una brillante studiosa. La sua intelligenza l’ha portata a ricoprire un ruolo importante nella storia della fisica. Per lungo tempo, tuttavia,…

La fisica quantistica consente di conoscere le leggi che regolano l’infinitamente piccolo giungendo a un intimo grado di comprensione della natura. Ci aspetteremmo una sorta…

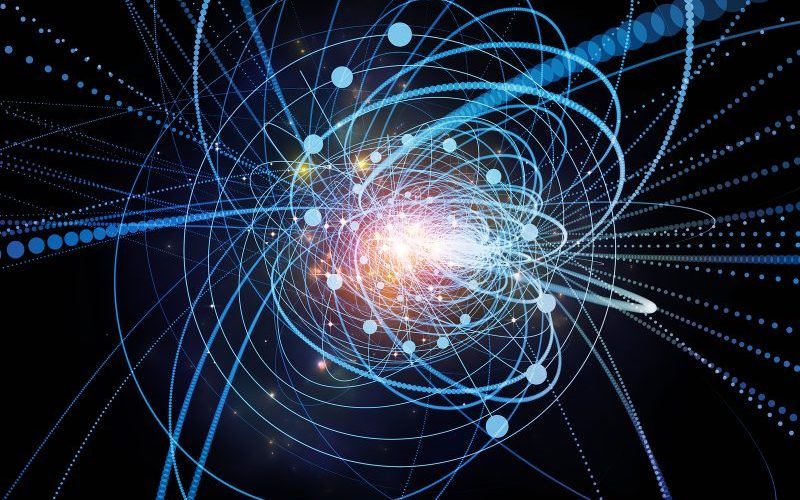

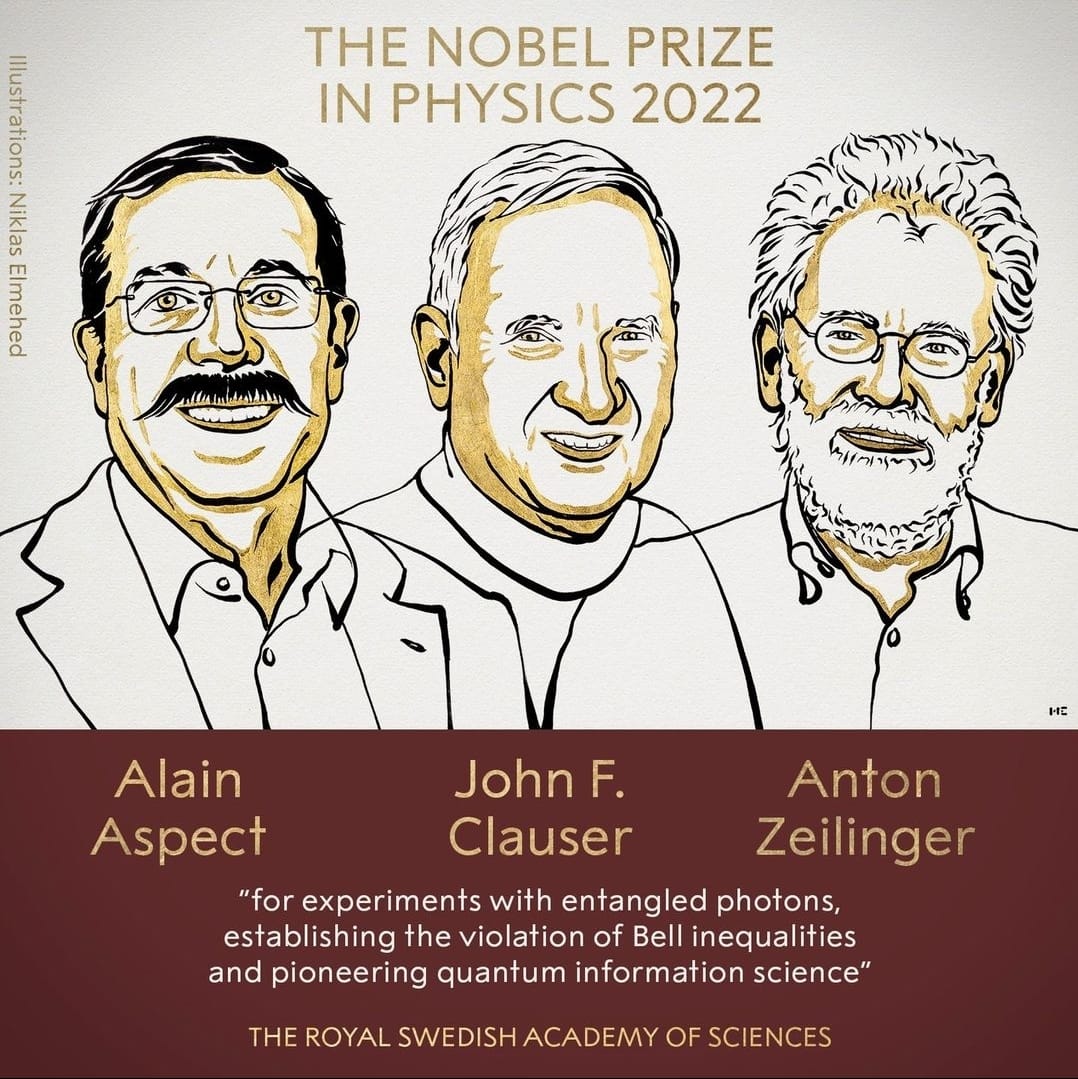

Il Nobel per la Fisica 2022 è stato assegnato a Alain Aspect, John F. Clauser e Anton Zeilinger «per i loro esperimenti con l’entanglement dei…

Dalla Cina arriva il Robot Melma che promette di rivoluzionare la biomedicina attraverso l’utilizzo di un nuovo materiale. La nuova scoperta promette applicazioni in aree…

Non importa se sei giovane o vecchio, uno studente o un avvocato di famiglia praticante, i film sui supereroi sono divertenti, stimolanti e pieni di riferimenti scientifici,…

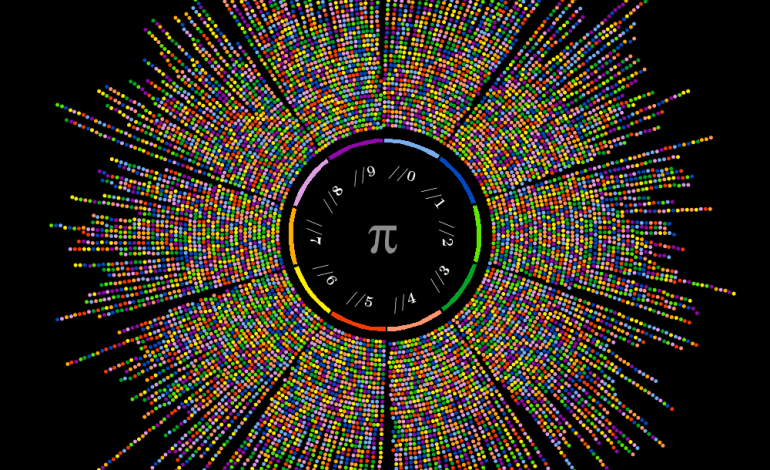

π. Sedicesima lettera dell’alfabeto greco, un piccolo carattere che rappresenta parte della nostra cultura. Questo simbolo, infatti, racchiude in sé una storia lunga millenni, colma…

La notte del 26 aprile 1986 presso la centrale nucleare di Chernobyl, nell’attuale Ucraina settentrionale, si è verificato quello che ancora oggi, dopo oltre trent’anni,…

“Che cosa c’è in un nome? Ciò che noi chiamiamo con il nome di rosa, anche se lo chiamassimo con un altro nome, serberebbe pur…